پژوهشگران شرکت اپل طی مطالعهای جدید نشان دادند که مدلهای استدلالی در مواجهه با مسائل پیچیده دچار فروپاشی کامل دقت میشوند.

به گزارش هیچ یک _ پژوهشگران اپل طی مطالعهای جدید نشان دادند که مدلهای «هوش مصنوعی» استدلالمحور، به آن اندازه که تبلیغ شدهاند، هوشمند نیستند و در واقع، این مدلها اصلاً توانایی استدلال واقعی ندارند. مدلهای استدلالی مانند «کلود»(Claude)، «o3» یا «R1»، «مدلهای زبانی بزرگ»(LLM) تخصصی هستند که برای تولید پاسخهای دقیقتر، زمان و توان محاسباتی بیشتری نسبت به نسخههای پیشین خود صرف میکنند.

به نقل از لایوساینس، رشد این مدلها باعث شده شرکتهای بزرگ فناوری بار دیگر ادعا کنند که ممکن است به آستانه توسعه «هوش جامع مصنوعی»(AGI) نزدیک شده باشند. این سامانهها در بیشتر وظایف از انسان بهتر عمل میکنند. با این حال، این مطالعه، ضربه بزرگی به این ادعا وارد کرده است. دانشمندان در این پژوهش میگویند مدلهای استدلالی نه تنها استدلال عمومی از خود نشان نمیدهند، بلکه با پیچیدهتر شدن وظایف، دقت آنها کاملاً فرو میریزد.

آنها در این مطالعه گفتند: ما با آزمایشهای گسترده روی پازلهای متنوع، نشان دادیم که مدلهای زبانی پیشرفته در مواجهه با پیچیدگیهای خاص دچار فروپاشی کامل دقت میشوند. علاوه بر این، آنها محدودیت مقیاسبندی عجیبی را نشان میدهند و تلاش برای استدلال در آنها تا حدی با افزایش پیچیدگی رشد میکند، اما سپس با وجود داشتن ظرفیت کافی برای پردازش، افت میکند.

مدلهای زبانی بزرگ با جذب دادههای آموزشی از حجم وسیعی از محتوای انسانی رشد میکنند. آنها با استفاده از این دادهها، الگوهای احتمالی را از طریق شبکههای عصبی خود تولید میکنند و هنگام دریافت یک ورودی، آن را به جلو انتقال میدهند. مدلهای استدلالی برای افزایش دقت «هوش مصنوعی» از فرآیندی موسوم به «زنجیره تفکر»(chain-of-thought) استفاده میکنند. این روش با استفاده از پاسخهای چندمرحلهای، الگوهایی را از دادهها دنبال میکند و تقلیدی از نحوه استفاده انسان از منطق برای رسیدن به نتیجه است.

این رویکرد به چتباتها امکان میدهد تا منطق خود را بازنگری کنند و به وظایف پیچیدهتر با دقت بیشتری پاسخ دهند. در طول این فرآیند، مدلها استدلال خود را مرحله به مرحله و به زبان ساده بیان میکنند تا قابل مشاهده باشد. با این حال، چون این فرآیند مبتنی بر حدسهای آماری است و نه درک واقعی، چتباتها به شدت مستعد توهم هستند. این امر به معنی ارائه پاسخهای اشتباه، دروغ گفتن در صورت نبود داده و گاهی ارائه توصیههای عجیب یا مضر است.

نویسندگان این مطالعه گفتهاند: ما معتقدیم که فقدان تحلیلهای نظاممند درباره این سوالات ناشی از محدودیتهای الگوهای ارزیابی فعلی است. ارزیابیهای موجود عمدتاً بر مبنای معیارهای ریاضی و کدنویسی هستند که با وجود ارزشمندی، اغلب دچار آلودگی داده هستند و امکان انجام آزمایشات کنترلشده در شرایط مختلف با پیچیدگیهای متغیر را نمیدهند. همچنین، این ارزیابیها بینشی درباره ساختار و کیفیت زنجیرههای استدلال ارائه نمیکنند.

جعبه سیاه هوش مصنوعی

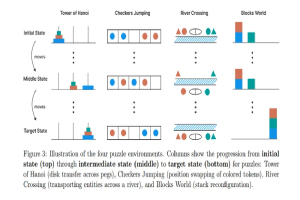

برای بررسی بیشتر این مسائل، نویسندگان این مطالعه، چهار پازل کلاسیک را به مدلهای جامع و استدلالی «هوش مصنوعی» دادند. آنها سپس با افزودن اجزای بیشتر به پازلها، پیچیدگی را در سه سطح، آسان، متوسط و سخت تنظیم کردند. در وظایف با پیچیدگی پایین، مدلهای عمومی بهتر از مدلهای استدلالی عمل کردند، زیرا بدون صرف هزینههای محاسباتی اضافی زنجیره استدلال، به پاسخ درست رسیدند. با افزایش پیچیدگی، عملکرد مدلهای استدلالی بهبود یافت، اما در مواجهه با مسائل بسیار پیچیده، عملکرد هر دو گروه به صفر، سقوط کرد.

پس از عبور از یک آستانه بحرانی، مدلهای استدلالی تعداد پردازشهایی که به وظایف پیچیده اختصاص میدادند را کاهش دادند که نشان میدهد میزان استدلال آنها کمتر شده و در حفظ «زنجیره تفکر» دچار مشکل هستند. حتی زمانی که راهحل به آنها داده میشد، همچنان با مشکلات مشابهی مواجه بودند.

این یافتهها نشان میدهد که مدلها بیشتر به تشخیص الگو و کمتر به منطق نوظهور تکیه میکنند. اپل نیز در مسابقه «هوش مصنوعی» از رقبای خود عقب افتاده است. این شرکت در عوض، توسعه «هوش مصنوعی» کارآمد و روی دستگاهها را با مدلهای استدلال بزرگ اولویت قرار داده است. برخی از دانشمندان «هوش مصنوعی» این مطالعه را به عنوان یک شوک اساسی بر ادعاهای بزرگ در مورد توانایی ابزارهای «هوش مصنوعی» فعلی برای تبدیل شدن به ابرهوش در آینده، ستودهاند.

«آندری بورکو»(Andriy Burkov) کارشناس «هوش مصنوعی» و سرپرست پیشین تیم یادگیری ماشینها در «شرکت تحقیقاتی گارتنر»(Gartner)، گفت: اپل برای «هوش مصنوعی» بیشتر از هر کس دیگری کار کرده است. آنها از طریق انتشارات داوری شده ثابت کردند که «LLMها» فقط شبکههای عصبی هستند و تمام محدودیتهای سایر شبکههای عصبی آموزش دیده را به روش نظارت شده دارند، که من و چند نفر دیگر سعی در انتقال آن داشتیم، اما سر و صدای گروهی از طرفداران «هوش جامع مصنوعی» و فریبکاران بیش از حد بلند بود.

وی افزود: اکنون، امیدوارم، دانشمندان با مطالعه «LLMها» علم واقعی بازگردند، مانند ریاضیدانان که توابع را مطالعه میکنند اما با آنها صحبت نمیکردند.